[인공지능] 네이버 클로바: 갈라파고스 vs 한국수성

[인공지능] 네이버 클로바: 갈라파고스 vs 한국수성 에 대해 리뷰하려고 합니다.

2023년 8월 24일 네이버 하이퍼 클로바 서비스가 오픈되었는데, 네이버 자체설명 기준 ChatGPT 3.5 버전보다 우수하지만, GPT 4.0 버전보다는 못하다고 자체 평가하고 있네요.

네이버, 갈라파고스 주도 vs 한국시장 수성

한국어 분석 및 생성에 특화되었다는 것은 좀더 검증을 해봐야 할 것 같고, 발표 당일날 서버가 다운되는 불상사까지 발생했네요.

네이버 클로바는 OpenAI의 GPT-3(175B)를 뛰어넘는 204B(2040억 개) 파라미터(parameter, 매개변수) 규모로 개발됐다. AI 모델의 크기를 나타내는 파라미터의 수가 높아질수록, AI는 더욱 많은 문제를 해결이 가능합니다.

하이퍼클로바는 GPT-3보다 한국어 데이터를 6,500배 이상 학습한, 현재 전세계에서 가장 큰 한국어 초거대 언어모델이기도 하다. 영어가 학습 데이터의 대부분을 차지하는 GPT-3와 달리, 하이퍼클로바 학습 데이터는 한국어 비중이 97%라고 합니다.

네이버가 버티는 한국 인터넷 업계는 갈라파고스화 되면서, 일본과 같이 글로벌 인터넷에서 제외되는 트렌드를 보이고 있는데, 한국 언론은 한국 시장 수성이라는 애국주의적 표현을 사용하고 있네요.

과연, 네이버와 카카오는 갈라파고스의 주역일까요? 아님, 한국 시장의 수호자인가요?

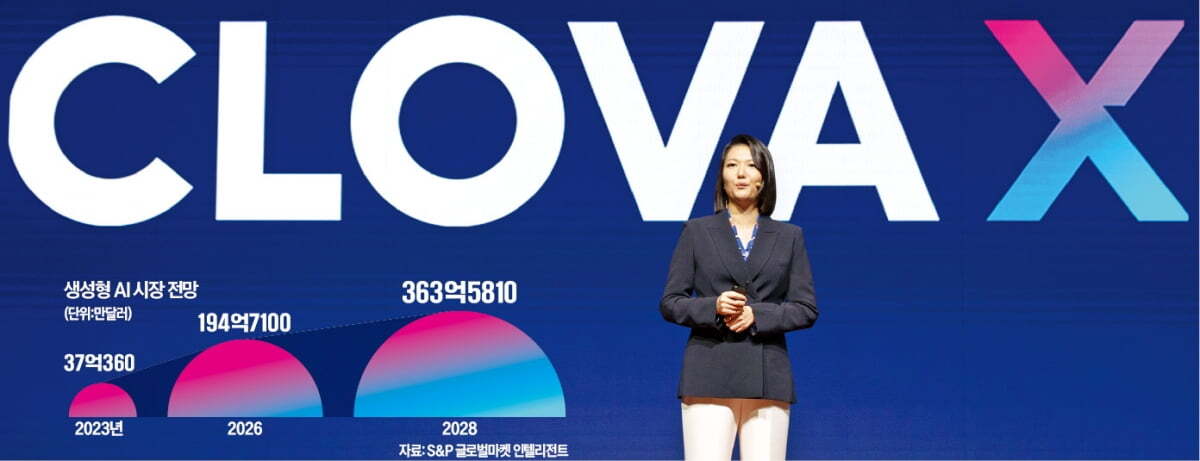

<서울경제, 2023년 5월 3일 기사>

현재 오픈AI의 챗GPT와 같은 생성형 AI는 영어권 국가에서 만들어지고 있는 만큼, 영어에 최적화된 토큰화 과정을 거친다. 반면 영어 이외의 언어는 문장 생성시 ‘알수없는토큰(Unknown token)’ 발생을 최소화하기 위해 토큰을 최소단위까지 쪼갠다.

한국어, 글자보다 토큰이 늘어나는 언어구조

예를 들어 ‘놀이터에 놀러가고 싶어.’라는 문장을 오픈AI의 챗GPT는 13개의 ‘글자(characters)’와 30개의 ‘토큰’으로 분류한다. ‘놀’이라는 글자하나를 자음과 모음을 각각 구별한 뒤 ‘ㄴ’, ‘ㅗ’, ‘ㄹ’이라는 3개의 토큰을 할당하는 구조이기 때문에 저 짧은 문장은 전체 토큰 수가 30개에 달한다.

반면 챗GPT는 ‘놀이터에 놀러가고 싶어’와 같은 뜻의 ‘I want to go to the playground.’라는 영어문장을 31개의 글자와 8개의 토큰으로 분류한다. 같은 뜻의 문장이지만 토큰화 과정에서 영어 문장이 한국어 대비 4분의 1 수준의 토큰이 사용되는 셈이다.

국내 기업은 이같은 부분에서 영어권 생성형 AI 대비 한국형 생성형 AI의 경쟁우위가 있다고 자신한다. 네이버 등 국내 기업은 한국어 문장을 띄어쓰기, 음절, 형태소 등을 기준으로 토큰화 할 것으로 전망된다. 이에 따라 ‘놀이터에 놀러가고 싶어.’라는 문장 생성에 필요한 토큰 개수도 3~10개 정도만 사용돼, 한국어 이용시 영어 기반의 생성형 AI 대비 전력소모 등이 크게 줄어들 전망이다.

하 소장은 “(빅테크의 생성형 AI 이용시) 유효 문맥창(context window)의 크기에서만 10배이상 손해를 보게 되며, 디코딩 속도 또한 10배 이상 손해볼 수밖에 없는 구조”라고 밝혔다. 네이버는 초대규모 인공지능 ‘하이퍼클로바’를 업그레이드 한 ‘하이퍼클로바X’를 오는 7월 공개해 ‘한국 AI 시장의 최강자는 네이버’라는 점을 다시한번 대내외에 선포할 예정이다. 네이버측에 따르면 하이퍼클로바X는 챗GPT 대비 한국어를 6500배 이상 학습했다.